声明:本文来源于微信公众号 量子位(ID:QbitAI),作者:梦晨,授权站长之家转载发布。

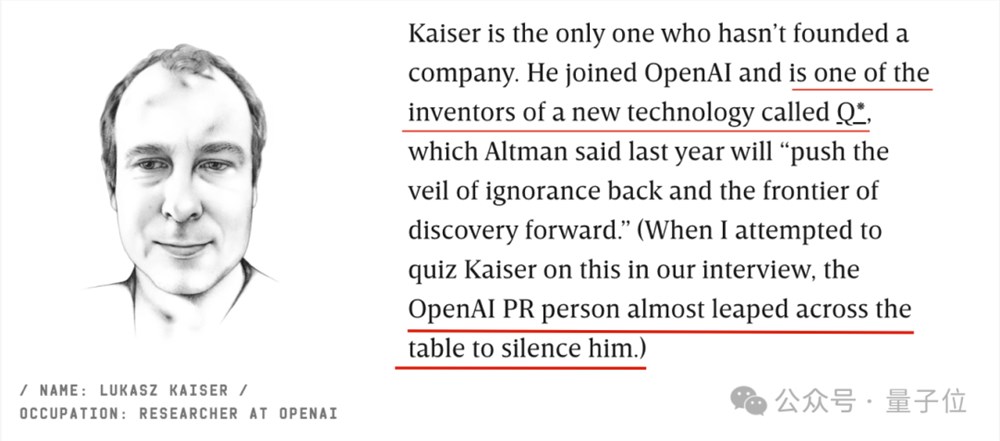

Transformer作者中唯一去了OpenAI该公开承认:

他是这项新技术的发明者之一,参与了Q*项目。

这几天,除了英伟达老黄组局聚集了Transformer的作者外,他们中的几人还接受了连线杂志的采访,期间出现了这样一个小插曲。

当记者试图询问时Lukasz Kaiser更多关于Q*的问题,OpenAI的公关人员几乎跳过桌子捂住他的嘴。

“我们还没有准备好谈论这个话题,”奥特曼在接受采访时毫不犹豫地拒绝了这个问题。

神秘的Q*已经成为OpenAI最保守的秘密之一。

然而,作者透露了Transformer背后的发展内幕,以及谷歌在获得该技术后未能首次推出轰动世界的人工智能产品:

Noam Shazeer(现在Character.人工智能创始人)是贡献最大的

谷歌早在2012年就试图开发生成的人工智能搜索

2017年,他们建议训练万亿参数大模型,但没有被高层采纳

总之,信息量远高于老黄圆桌论坛上的几个商业互吹。

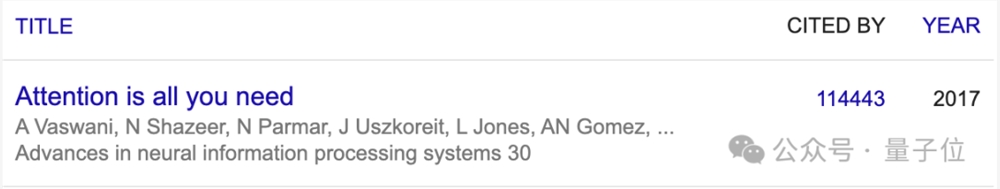

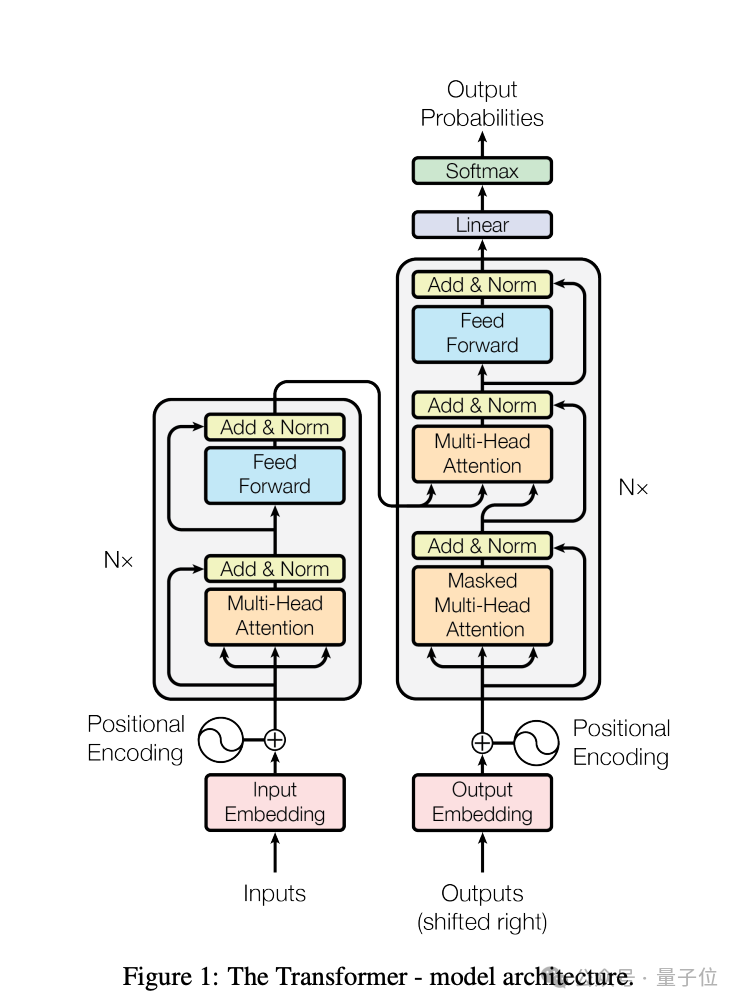

《Attention is all you need》发表于2017年,至今已被引用超过11万次。

它不仅是以ChatGPT为代表的大型模型技术的起源之一,也是Soransformer架构和注意力机制的介绍、许多改变世界的AI技术,如AlphaFold,都是当之无愧的传奇。

为什么谷歌能取得这样的成就?为什么谷歌在后来的大模型竞争中落后?

整个故事要从2012年开始。

2011年底,苹果正式推出Siri,试图在对话中提供答案。

谷歌的高管们认为Siri可能会抢走他们的搜索流量。

2012年,一个团队致力于开发新功能,希望能够直接回答用户在搜索页面上的问题,跳转到其他网站而不需要点击链接。

最后,这项努力催生了Transformer架构,可以有效扩展数据和计算能力,导致整个人工智能领域的重大突破。

Jokob Uszkoreit(现AI生物技术公司Inceptive联合创始人)就是在这个时候放弃攻读博士学位加入这个团队,成为Transformer的初始起点。

他来自德国,硕士毕业于柏林理工大学,父亲Hans Uszkoreit着名欧洲科学院计算语言学家和院士。

现在看来,谷歌高管对Siri的恐慌是不必要的。Siri从未真正威胁过谷歌的业务,但他很高兴有机会深入研究人工智能和对话系统。

2012年,当AlexNet在计算机视觉和神经网络复兴方面取得巨大成功时,谷歌疯狂地安排员工尝试类似的技术,希望开发自动完成电子邮件或相对简单的客户服务聊天机器人的功能。

当时最公认的方案是长期和短期记忆网络LSTM,但该技术只能按顺序处理句子,不能有效地利用文章背后可能出现的线索。

直到2014年左右,乌兹哥才开始尝试现在被称为“自我注意”的方法。

乌兹哥认为,自注模型可能比循环神经网络更快、更有效,处理信息的方式也非常适合GPU。

但当时很多人并不乐观,包括他的学术大牛的父亲,认为抛弃循环神经网络是一个异端。

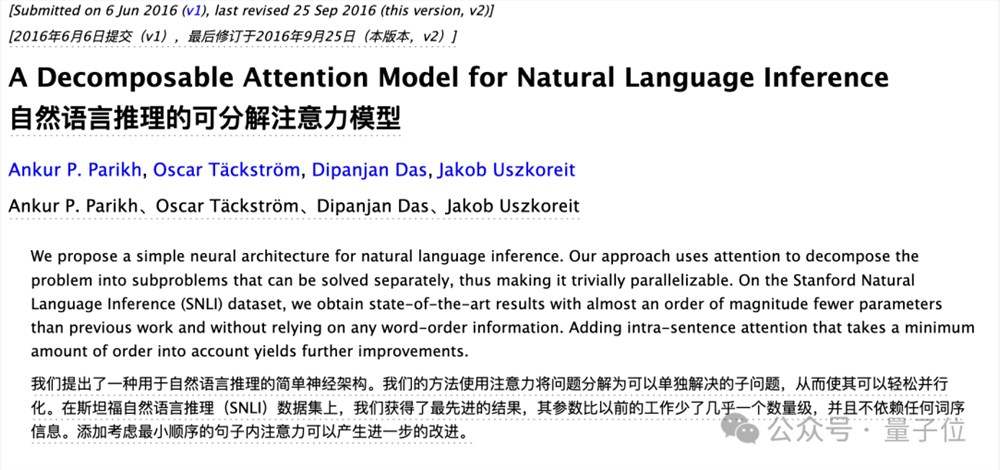

乌兹哥花了一些精力说服几位同事一起实验新想法,并于2016年发表了一篇相关论文。

在这项研究中,只使用了很少的文本训练(SNLI数据集,包括57万人写的英语句子)。

乌兹哥希望进一步推进他们的研究,但他的合作伙伴对继续不感兴趣。

其他研究人员就像在回答正确的问题时带着微薄的奖金离开,但乌兹哥坚持认为自我注意机制可以发挥更大的作用,并开始在公司里到处寻找安利他的想法。

2016年的一天,他终于遇到了志同道合的人Illia Polosukhin(NEARR现在是区块链公司 Protocol创始人)。

Polosukhin(后简称菠萝哥)当时在谷歌工作了三年,被分配到直接为搜索问题提供答案的团队。

由于从用户体验出发,菠萝哥的进展并不顺利,需要在几毫秒内回应问题,当时没有这么高性能的解决方案。

乌兹哥和菠萝哥一起吃午饭,安利毫不犹豫地开始了他的自我注意机制。

菠萝哥曾透露,他后来觉得A的注意力就像科幻小说一样《你一生的故事》以及电影的改编《降临》内外星人的“七肢桶”语言没有顺序,而是像几何图案一样样排列。

总之,菠萝哥后来不仅同意尝试,还带来了第三个成员Ashish Vaswani合作(Adeptt先后创立) AI和Essential AI)。

Vaswani(以下简称瓦斯哥)来自印度,博士毕业于南加州大学后加入谷歌大脑。我相信神经网络将促进人类的整体理解。

三位研究人员共同起草了Transformer的设计文件第一从一开始,我就选择了同样的代表“变形金刚”这个名字,因为“系统会改变接收到的信息”,也因为菠萝哥小时候喜欢玩变形金刚玩具。

然而,菠萝哥很快就离开谷歌创业了。与此同时,其他成员也加入了这个小团队。

2017年初,第四名成员Niki Parmar(以下简称帕姐)加入,他和瓦斯哥也来自印度,也毕业于南加大,后来两人也成为了创业伙伴。

后几位成员的加入有些戏剧性。

第五位Llion Jones(后来简称尴尬哥)来自英国,2009年毕业于伯明翰大学,但几个月找不到工作靠救济金。2012年,他先加入Youtube团队,然后进入谷歌研究院。

去年,他在日本成立了Sakana,这是团队中最新离开谷歌的球员 AI。

从另一位同事那里,尴尬的哥哥Mat Kelcey(他只出现过一次,不用简称)那里听说过Transformer,但Kelcey当时并不看好这个项目。

Kelcey相信贝叶斯,他的头像是AI预测他是技术宅的概率为60%。后来他以为没有加入Transformer团队,这是他一生中的事最大预测错误。

话说回来,第六位Aidan Gomaz(后来简称割麦,现任AICohere创始人)是最年轻的。他在多伦多大学大三的时候加入了Hinton的实验室,主动给谷歌里写过有趣论文的人发邮件申请合作。

第七位Lukasz Kaiser(后来简称凯哥,现在OpenAI研究员)邀请割麦参加实习。直到几个月后,割麦才知道实习是针对博士生的,而不是本科生。

凯哥来自波兰,最初从事理论计算机工作。后来,他发现自我关注是一个有前途、更激进的解决方案,这是他们当时正在解决的问题(可分布式计算的大型自回归模型)。他们加入了Transformer团队。

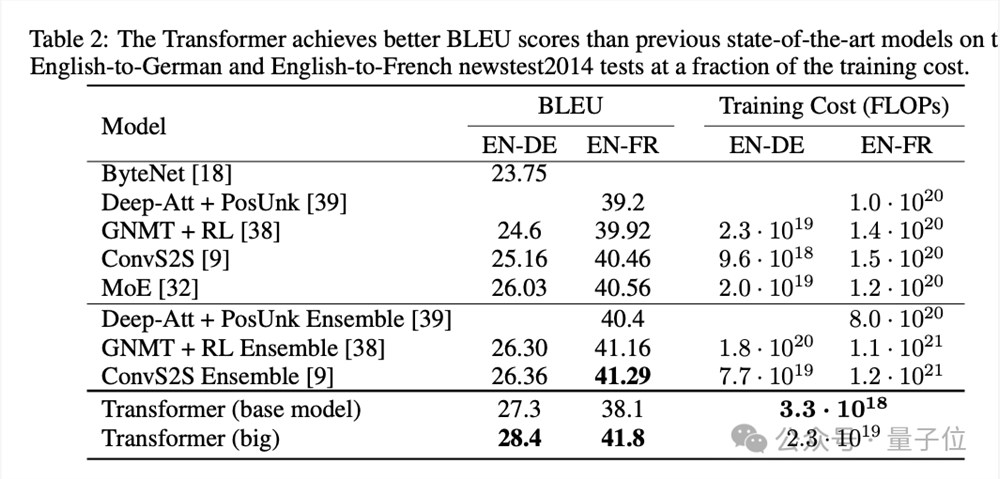

六个人(菠萝哥已经创业了)聚在一起后,团队开始把测试方向定在一起机器翻译,将模型翻译结果与人工翻译进行比较,采用BLEU基准测试。

Transformer原型早期表现不错,但与LSTM方案相似,并非更好。

此时,第八名关键成员Noam Shazeer(后简称沙哥)出场,他毕业于杜克大学,2000年加入谷歌,当时全公司只有200人左右,

后来,他成为了谷歌内部的传奇人物,参与了谷歌搜索的拼写和纠正功能,并负责早期的广告系统。2021年离开谷歌后,他创立了character.AI。

根据沙哥的记忆,当时他走在办公楼的走廊里。当他经过凯哥的车站时,他听到了一场激烈的对话:瓦斯哥正在谈论如何使用他的注意力,帕姐姐对此非常兴奋。

沙哥认为这是一群有趣的聪明人在做有前途的工作,最终被凯哥说服加入。

至此,八位传奇人物终于全部登场。

沙哥的加入非常重要,他用自己的想法重新编写了整个代码,并将整个系统提升到了一个新的水平。

这个团队充满了动力,开始拼命地卷起自己,希望在2017年NIPS(NeurIPS后更名)截止日期前的5月19日完成。

在Deadline之前的最后两周,他们大部分时间都在咖啡机附近的办公室,很少睡觉。

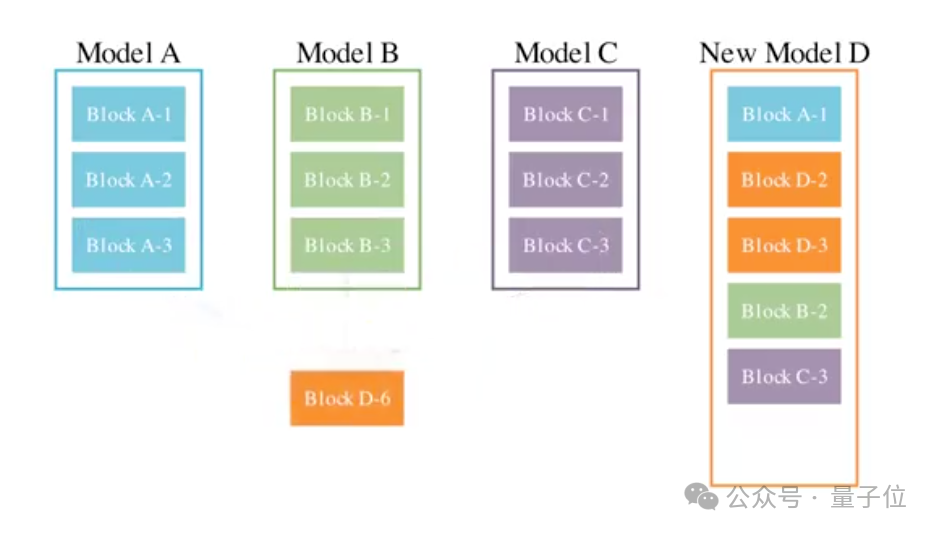

切麦作为实习生,不断疯狂调试,测试各种技能和网络模块的排列组合。

最后,在沙哥的帮助下,人们现在知道的Transformer架构诞生了,与实验中的其他方案相比非常重要“极简主义”。他们这样评价:

Noam(沙哥)是个巫师。

沙哥很厉害,但沙哥并不自知。当他看到论文草稿时,他发现自己很惊讶。

经过一番讨论,他们最终决定打破学术界一作二作通讯的规则,随机排序,并在每个人的名字后打上星号,脚标注为平等贡献者。

在给论文取名的阶段,来自英国的尴尬哥哥建议借用披头士乐队的歌曲《All You Need Is Love》,改成《Attention is all you need》,其他人也同意了。

他们训练了基础和大杯模型,其中65M基础版击败了同级别的所有竞争对手,213M大杯版甚至打破了BLEU测试的记录,计算效率更高。

在截止日期的最后几分钟,他们继续收集实验结果,英法翻译的数据是在最后五分钟出来的,论文在最后两分钟提交。

当时学术会议审稿人反应不同,一个评价积极,一个评价非常积极,第三个评价只是“还可以”。

这篇论文在12月会议正式线下举行时引起了轰动。四个小时的会议上挤满了想了解更多的科学家。

几位参加会议的作者一直在谈论嘶哑的声音。最后,当场地关闭时,仍然挤满了人,最后被保安清理。

从Transformer诞生的整个过程来看,谷歌开放包容的文化必不可少:

这八个人聚在一起,靠走廊里的偶遇和午餐聊天。

回到论文写作过程中的一天,瓦斯哥累得瘫倒在办公室的沙发上,盯着窗帘看幻觉,觉得布上的图案就像突触和神经元。

那天他突然意识到,他们正在做的事情将超越机器翻译。

最后,就像人脑一样,所有的声音、视觉和其他模式都统一在一个架构下。

沙哥在应用方向上有着惊人的远见。论文发表前后,他给谷歌高管发了一封信。

他提议公司放弃整个搜索引,并用Transformer架构训练一个巨大的神经网络替代,基本上是建议谷歌改变整个信息组织的方式。

在那个时候,球队里凯哥仍然认为这个想法很荒谬。但是现在看来,谷歌正朝着这个方向努力,这只是时间问题。

乌兹哥后来复盘,谷歌有机会在2019年或2020年推出GPT-3,甚至GPT-3.5级模型,并提出灵魂问题:

我们看到了可能性,但为什么不采取行动呢?

结果是OpenAI的首席科学家Ilya Sutskever在论文发表当天就意识到了“它给了我们想要的一切”,并且推荐Alec的同事 Radford开始动手研究。

Radford先开发GPT原型,然后OpenAI调动更多人从机器人、DOTA游戏等项目转型,参与GPT-1的开发、GPT-2...这是另一个故事。

Transformer架构的出发点是构建一个可以同时扩展数据和计算能力的模型,也是其成功的关键。

但是没有顶层设计和推广,谷歌只能在这里停下来,员工自发无法组织满足Scaling的需求 Law发展所需的人力、物力和财力。

OpenAI的组织形式既有自下而上的灵活性,又有自上而下的专注力,在这条路上走得更远几乎是不可避免的。

OpenAI 首席执行官奥特曼曾评论说,谷歌高层似乎没有人意识到Transformer真正意味着什么。

现在八位作者也陆续离开谷歌,既然公司迟迟不肯用Transformer做事,那就自己去做吧。

除了最早离开菠萝哥的区块链公司外,其他成员的下落都与Transformer有关。

2019年,实习生割麦子毕业后不久,我就带头创办了Cohere,目前估值22亿美元,为企业提供大模型解决方案。

从2021年开始,成员们集中出走。

瓦斯哥和帕姐先后携手创立Adept AI(估值10亿美元)、Essential AI(融资800万美元)是自动化工作流程的方向。

沙哥创建了AI角色扮演聊天平台Character.AI,目前估值约50亿美元,用户活动和留存率高于OpenAI。

乌兹哥回到德国创办的生物人工智能技术公司Inceptive,估值3亿美元。甚至乌兹哥也透露,他的计算语言学家的老父亲也在基于Transformer,为一家新的人工智能公司做准备。

只有凯哥没有创业,2021年他加入了OpenAI,后来参加了GPT-4和Q*项目。

最后离开的是尴尬的哥哥,他在日本创立了23年。Sakana AI估值2亿美元,最新结果是将不同领域的大模型融合起来,结合进化算法制作出更强的模型。

……

许多谷歌老员工批准谷歌逐渐从一个以创新为中心的游乐场转变为一个注重利润的官僚机构。

即使在2020年谷歌Meena聊天机器人发布后,沙哥也发了一封内部信“Meeena吞噬世界”,关键结论如下:

语言模型将以各种方式越来越多地融入我们的生活,并将在全球计算能力中占据主导地位。

这太有前瞻性了,几乎准确预测了ChatGPT时代后来发生的事情,也就是现在进行的时候。

但当时谷歌高层还是不为所动,关键决策者忽略甚至嘲笑他。

谷歌曾经拥有整个AI王国的所有钥匙,却失去了钥匙链。

参考链接:

[1]https://www.wired.com/story/eight-google-employees-invented-modern-ai-transformers-paper/

[2]https://www.youtube.com/watch?v=zbk2CPka5jo

[3]https://www.semianalysis.com/p/google-gemini-eats-the-world-gemini

Copyright © 2013-2025 bacaiyun.com. All Rights Reserved. 八彩云 版权所有 八彩云(北京)网络科技有限公司 京ICP备2023023517号

本站文章全部采集于互联网,如涉及版权问题请联系我们删除.联系QQ:888798,本站域名代理为阿里云