声明:本文来源于微信公众号 新智元(ID:AI_era),作者:新智元,授权站长之家转载发布。

【新智元导读】就在昨天,百川智能Baichuan2-Turbo系列API正式发布,192K超长上下文窗口+搜索增强知识库,解决了困扰行业已久的大型商业落地问题。

现在已经基本划定了大模型战争的战场格局。

截至目前,全国已有200多个大型模型,未来新模型的增量和增长率将继续放缓,应用侧的竞争将越来越激烈。

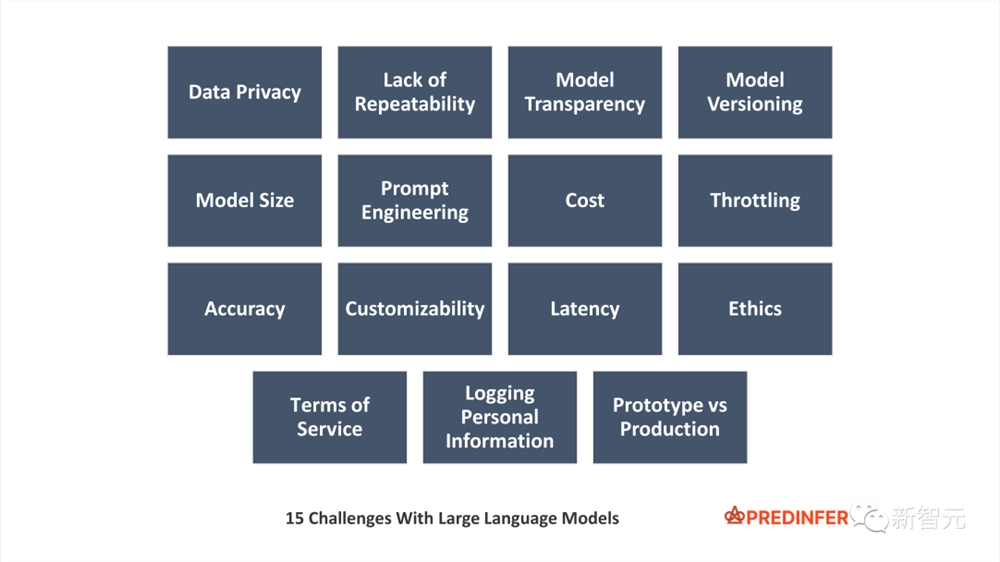

然而,一些公认的问题尚未解决,如幻觉、垂直领域知识难以获取、数据及时性不足、数据集不可预测、分词器依赖、推理延迟高、上下文长度有限、微调成本等。

在这种情况下,如何打破局面?

百川智能给出的答案是——

搜索增强是大模型应用的关键,大模型+搜索是大模型着陆应用的完整技术栈。

为此,百川智能打造了基于搜索增强的Turbo系列API-Baichuan2的全新搜索增强知识库-Turbo-192K和Baichuan2-Turbo。

在此基础上,企业可以通过API直接定制更完整、更高效的智能解决方案。

一波又一波的体验来袭

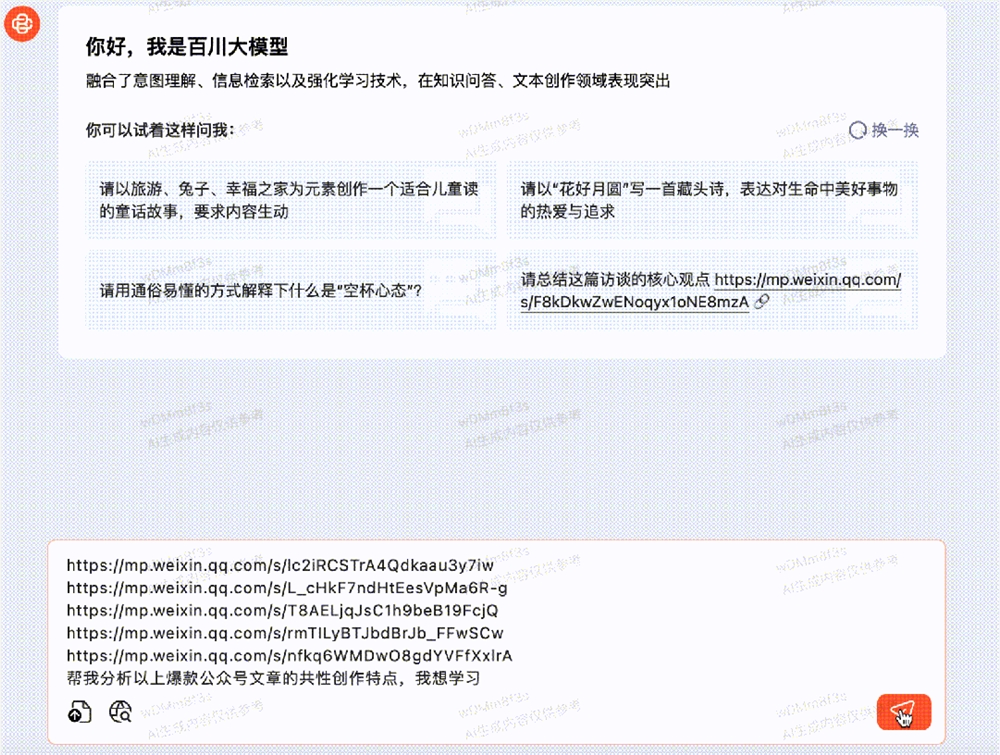

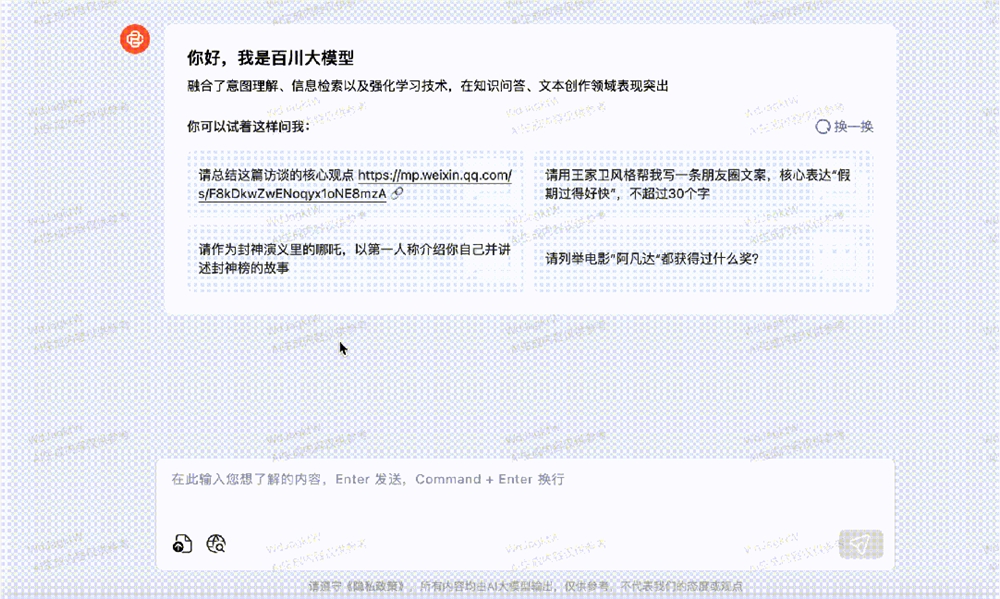

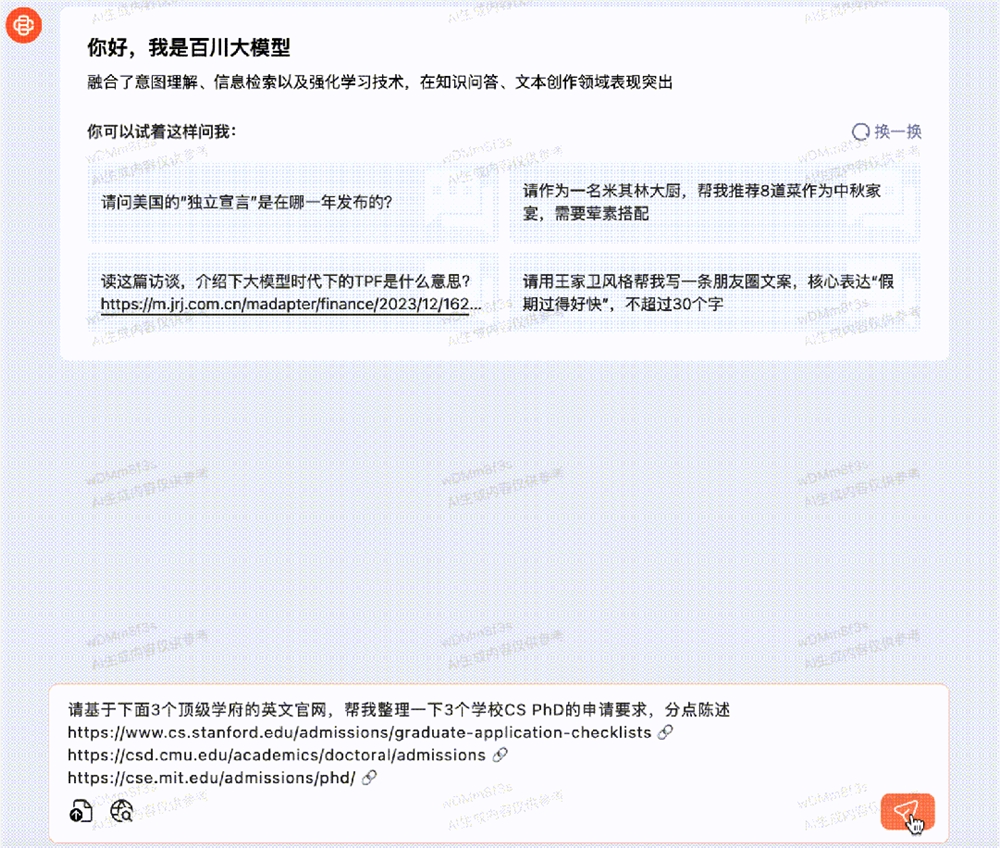

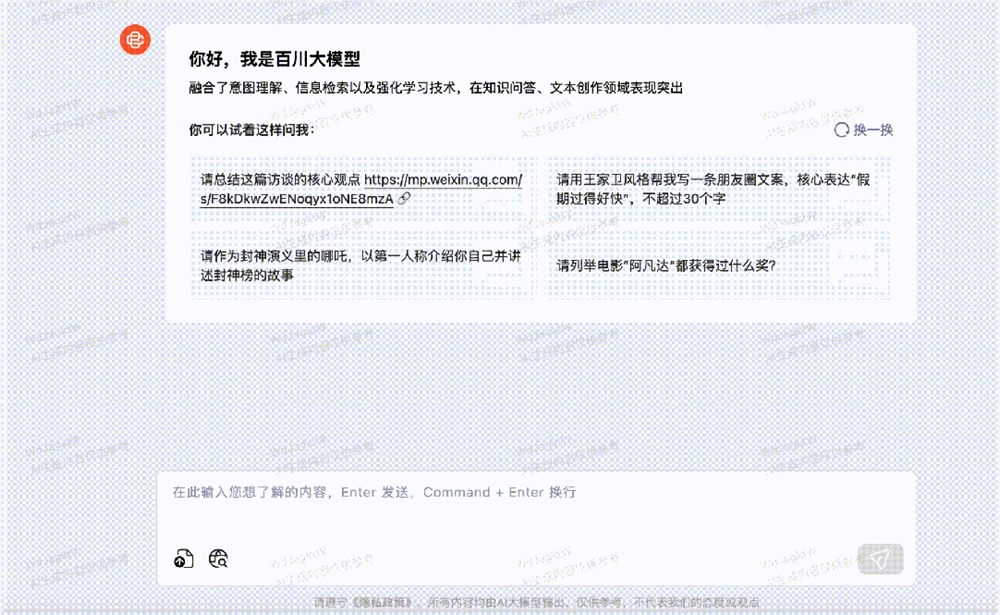

虽然很难展示API的完整体验,但我们可以通过百川智能官网的模型窥视豹的感受搜索增强带来的体验升级。

现在,你可以直接扔给Baichuan2-Turbo-192K公众号文章链接 ,让它总结一下这些爆款文章的共性。

将22年第四季度18页28k的特斯拉财务报告总结拖入Baichuan2-Turbo-192K一次性输出会议记录,包括财务业绩和市场需求、产品和技术开发、企业战略和未来规划等。

商品房销售合同长达51k,卖方、买方、建面、价格等重要元素,可按JSON格式输出。

连申请CS PhD,Baichuan2可以直接发送三所学校的官方网站地址-Turbo-192K将迅速整理申请Stanford 、CMU、MIT CS博士的具体要求。

Baichuan2-Turbo-192K最多可上传20份文件,每份最多可上传50M。

相比之下,Claude最多可以传输5个文件,每个文件最多可以传输10M。

为什么LLM商业落地这么难?

自ChatGPT问世以来,大模型已经蓬勃发展了整整一年。然而,在商业着陆领域,并没有取得非常理想的效果。

至于原因,我们不妨先全面了解一下「大模型」落地应用,到底是什么样的。

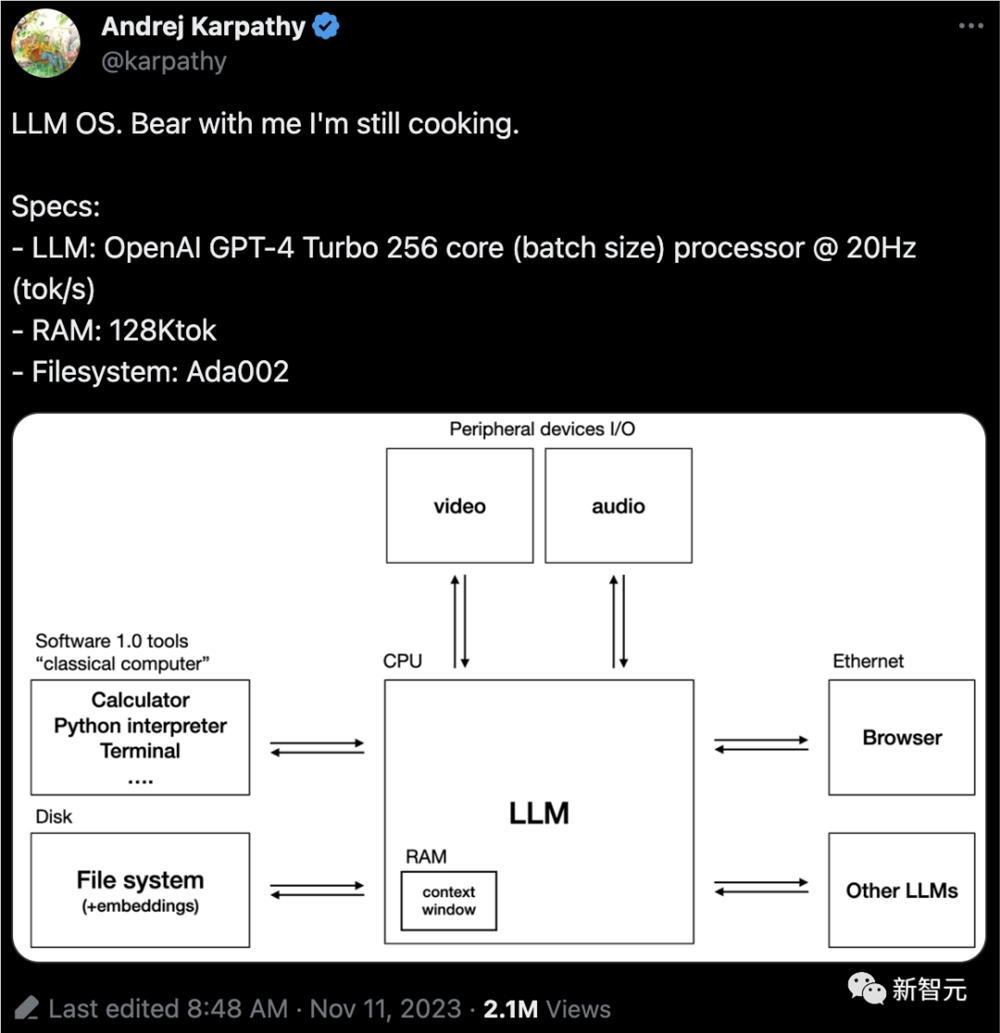

今年11月,OpenAI着名科学家Andrej Karpathy提出了一个全新的想法——「大模型操作系统」。

巧合的是,百川智能也有类似的认知,认为大模型时代的计算机主要包括以下几个部分:

其中,大模型相似「CPU」,通过预训练将知识内化到模型中,然后根据用户的Prompt生成结果;上下文窗口可视为「内存」,存储目前正在处理的文本;互联网信息和企业知识库共同构成了该系统「硬盘」。

当我们把它比作最常见的计算机时,商业化困难的原因是显而易见的。

作为基于Transformer架构的CPU大模型,它是一种在海量数据上进行预训练的概率预测模型,以参数的形式将知识内化到模型内部,不清楚,在预训练过程中,通用大模型对长尾知识分配的权重相对较小。

对于一些非常重要但数据量很小的知识,虽然也会内化到模型中,但在输出时不会给出太大的权重,因此存在先天缺陷,如幻觉、及时性差、缺乏专业知识等。

互联网信息和企业知识库存存存存存在「硬盘」在里面,如果大模型在训练中既不学习,也不能随时访问,那么专业知识就会有差距。

大模型+搜索增强是一个完整的技术栈

对于商业大模型来说,最重要的是解决企业的问题。

要满足千行百业的需求,模型必须学习这些垂直领域的专业知识。

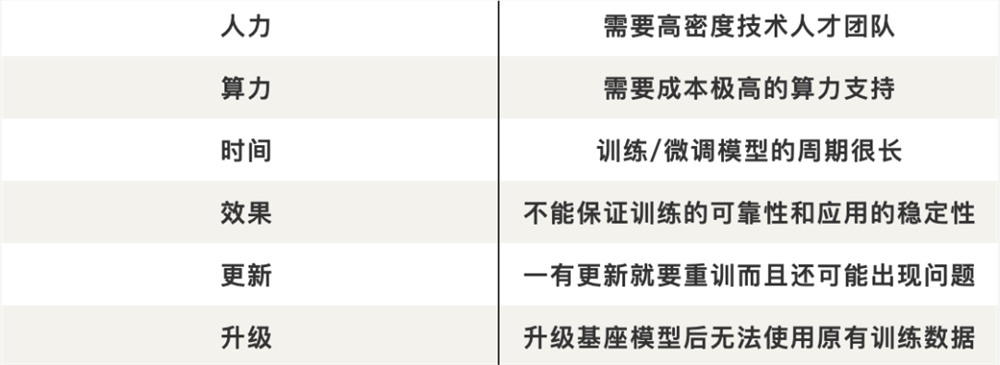

在商业化初期,为了解决通用大模型领域知识匮乏的问题,各行业的大模型层出不穷。

然而,新的问题随之而来。——

此外,大多数企业数据都是结构化数据,模型无法准确记忆,不适合微调。

为了解决传统方法的缺陷,学术界和行业都认为长上下文窗口和向量数据库是两种更好的方法。

在学术研究领域,主要的研究方向是「知识注入」和「知识利用」,将LLM与外部知识相结合,缓解问题。

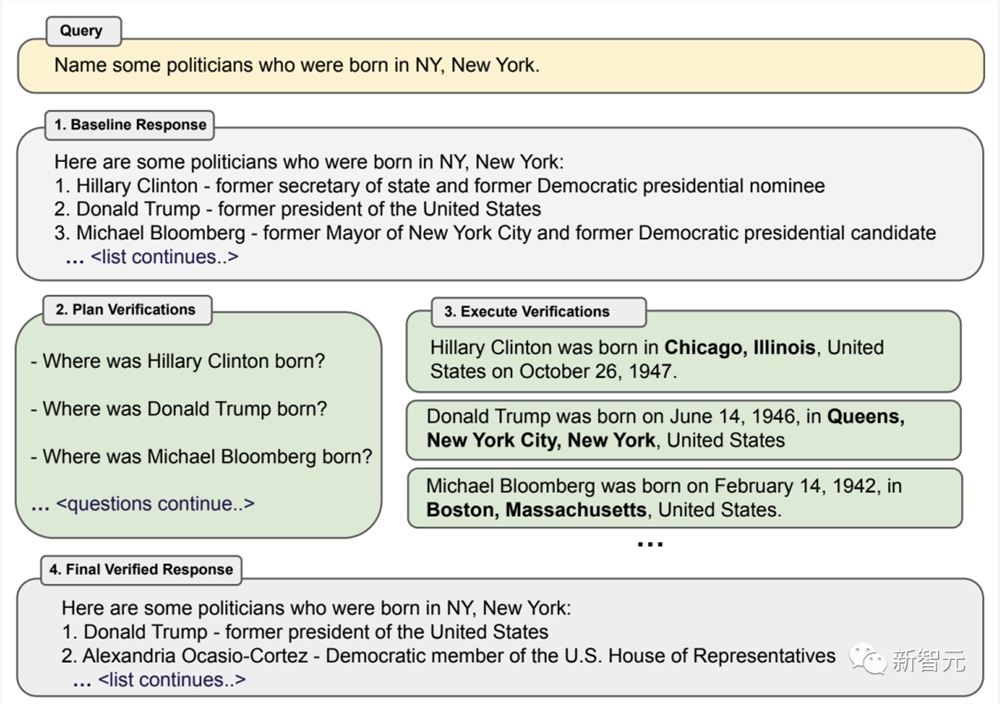

大多数人熟悉的是,2021年Opena发布的WebGPT允许GPT-3通过浏览引擎获取外部知识;Meta提出的Cove(验证链)提示工程方法允许模型访问外部数据库来验证问题。

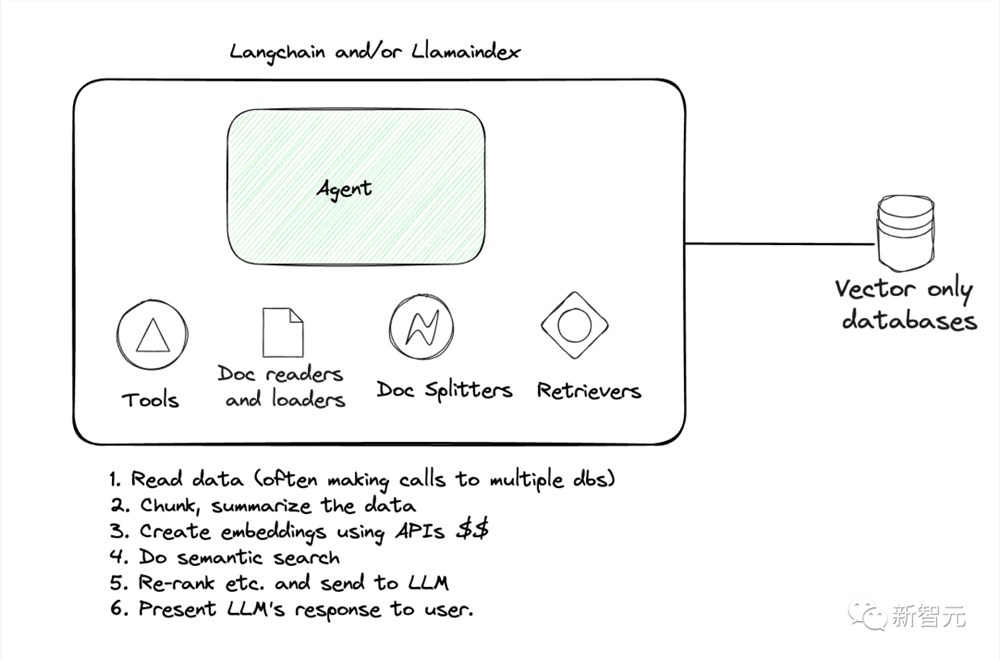

在工业领域,LangChainin是开源RAG生态最典型的代表、Lamma Index,开发者通过提供专门构建RAG应用程序的组件,包括分割器、数据库等,方便构建应用。

在OpenAI首届开发者大会上,他发布了自己的RAG产品Retrieval检索工具——OpenAI Assistants API,它打破了对向量数据库的限制。

另外,亚马逊云技术此前推出了OpenSearch。 Serverless向量引擎工具为用户提供了一个简单、可扩展、高性能的类似搜索功能,使生成人工智能落地。

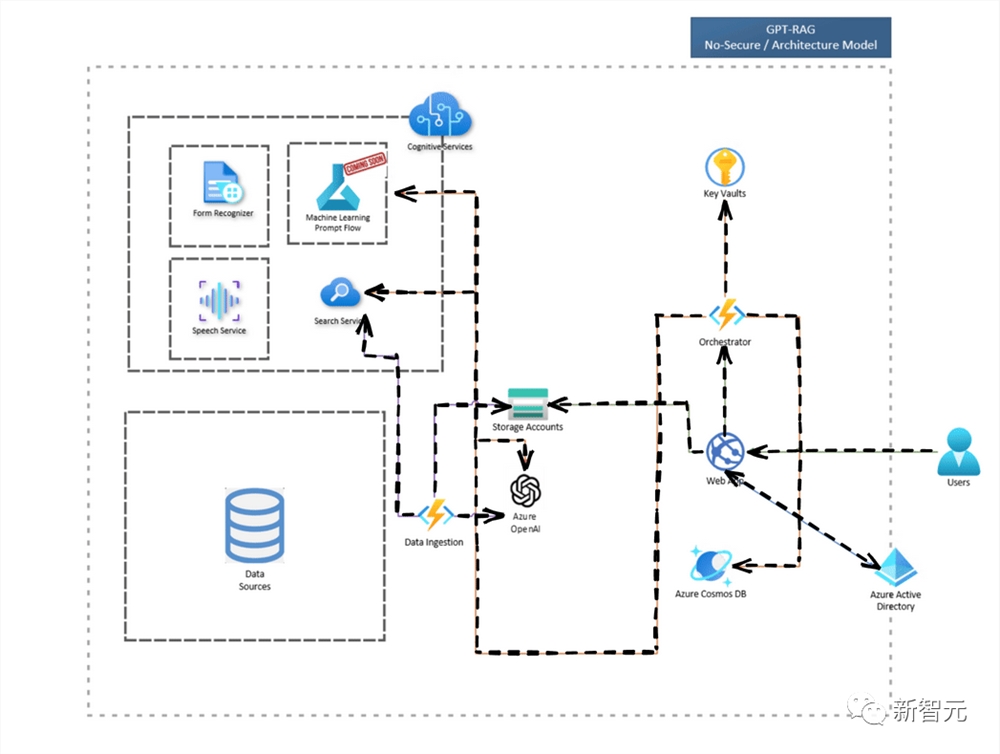

就在最近,微软Azure也推出了企业级解决方案——GPT-RAG。用户可以直接使用现有模型进行处理最新数据。在此期间,不仅不需要繁琐的微调,还可以保证响应的准确性,大大简化了大语言模型在企业中的应用集成过程。

在此基础上,百川智能不仅将向量数据库升级为搜索增强知识库,大大提高了大型模型获取外部知识的能力;还将搜索增强知识库与超长上下文窗口相结合,使模型能够连接所有企业知识库全网信息。

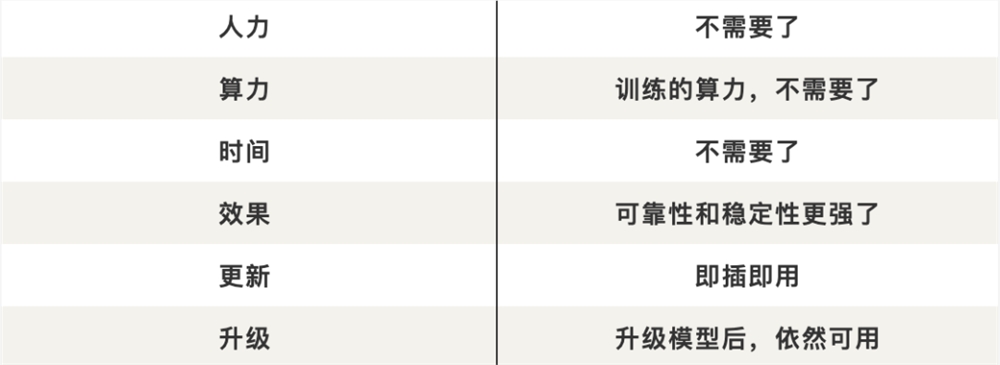

该方法不仅可以为企业节约巨大成本,还可以更好地实现垂直领域知识的沉淀,使专有知识库真正成为企业不断增值的资产。

百川智能表示,这个「长窗口模型+搜索增强」这种方式将能够取代大多数企业的个性化微调,解决99%企业知识库的定制需求。

因此,商业落地的各种问题都被一一打破了!

随着幻觉和及时性问题的解决,大型模型的可用性也得到了有效的提高,从而更好地为智能客户服务、知识问答、合规风险控制、营销顾问等行业的金融、政府事务、司法、教育等场景提供支持。

同时,与微调相比,搜索增强显著降低了应用成本,同时提高了可用性,使更多的中小企业能够享受到大模型带来的变化。

多项创新突破,克服搜索增强两大技术难点

但要实现搜索增强,必须解决两个难题。

在大模型时代,用户信息需求的表达方式发生了巨大的变化。用户在输入方式上的问题不再是一个单词或短句,而是一个更自然的对话互动,甚至是多轮连续对话。

问题的形式也更加多样化,与上下文密切相关。输入风格更口语化,输入问题更复杂。

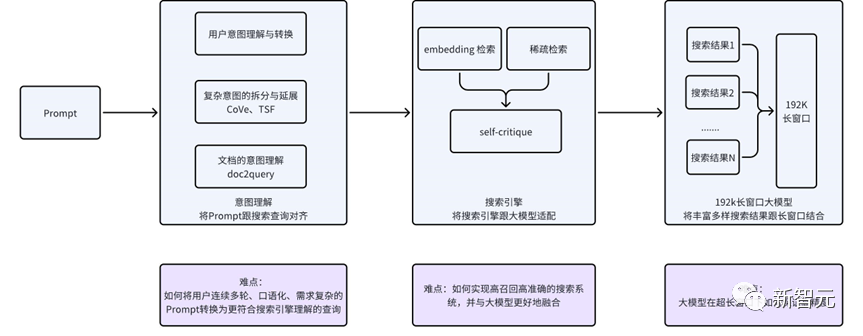

百川知识库旨在理解和微调自主研发的百川语言模型,可以将用户连续多轮口语Prompt信息转换为更符合传统搜索引擎理解的关键词或语义结构。

通过这种方法,我们可以更好地桥接新的用户需求表达与现有搜索技术之间的差距。

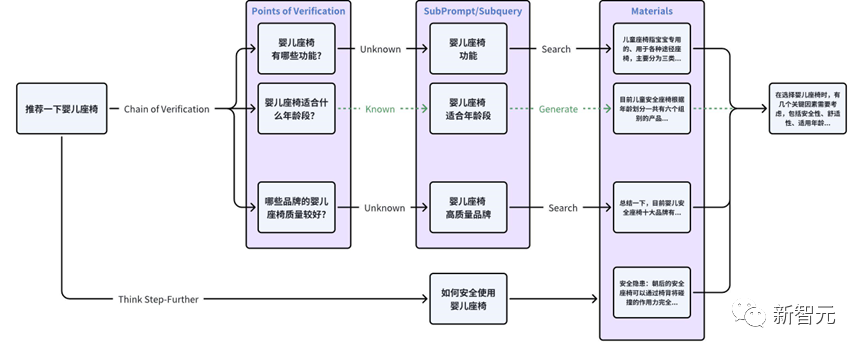

为了满足用户的复杂需求,团队借鉴了Meta的Cove技术,通过大模型转换和对齐真实场景中用户的复杂Prompt,进一步分为多个独立并行搜索的搜索友好查询。

此外,自主研发的TSF(Think Step-Further)技术,能使系统洞察用户输入背后的深层问题。

另外,团队还采用了一种独特的doc2prompt技术,以增强文档与prompt之间的对齐。

通过生成与文档内容密切相关的Prompt,可以提高系统对用户意图的捕捉精度,使检索结果更加准确。

用户需求与搜索查询的匹配程度越高,大型模型的输出效果越好。

为了进一步提高知识获取的效率和准确性,模型不仅需要更好地理解用户的意图,还需要更强的检索和召回解决方案。

虽然Embedding模型可以很好地解决用户需求和知识库的语义匹配问题。

然而,在知识库场景中,用户数据通常是私有化的。

在这种情况下,Embeding模型存在严重的退化问题,需要结合稀疏检索和Embedding模型技术实现高召回、高精度的检索系统。

此外,对于搜索系统召回的结果,需要通过搜索和大模型的协同优化来更好地理解和应用大语言模型。

-百川自研Baichuan-Text-Embedding(BCTE)C-MTEB榜模型顶C-MTEB榜单

由于大模型领域的积累,团队使用了超过1.5T tokens高质量的中文数据进行预训练,通过自主研发的损失函数,解决了对比学习对batchsize的依赖。

最终,Baichuan-Text-Embedding(BCTE)模型在最权威Top1在C-MTEB榜单上取得了成绩。

C-MTEB的六项任务(分类、聚类、文本推理、排序、检索、文本相似性)都大大领先

- 稀疏检索模型

稀疏检索模型的主要缺点是只能匹配单词,不能泛化为语义匹配。

对此,团队将稀疏检索与Rerank模型相结合。

与只使用Embedding检索的开源方案(目标文档召回率低于80%)相比,效果有质的提高——

未经私有化数据微调的Embedding模型可达86%,结合稀疏检索模型甚至可达95%。

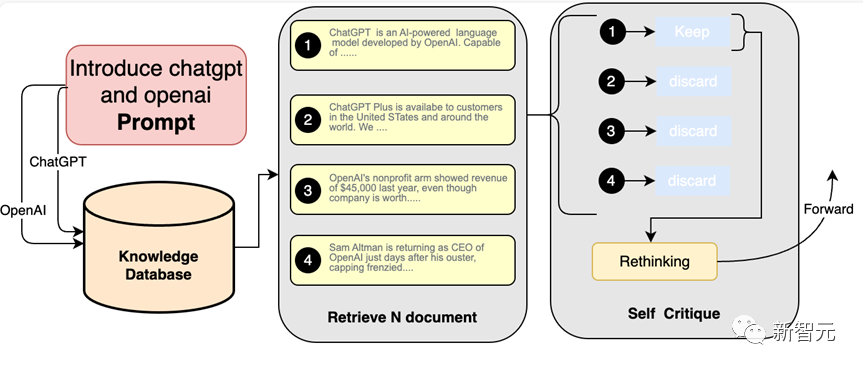

- 第一个Self-critique大模型自省技术

在当前阶段,在与企业知识库相结合的过程中,存在着需求不匹配的痛点,因此增加了「幻觉」现象。

在通用RAG技术的基础上,百川搜索增强知识库RAG深度融合知识库搜索,开创了Self-critique大模型自省技术。

这样,大型模型就可以从相关性和可用性的角度反思检索内容,最终筛选出来最优质的内容。

「长窗+搜索」5000万tokens的高效、高质量的信息回答精度为95%

最初的大模型窗口通常只有2K-8K,这给开发者带来了各种各样的问题,比如将长文本切成非常小的片段(chunk),模型很容易忘记自己的个人设计和所说的话等等。

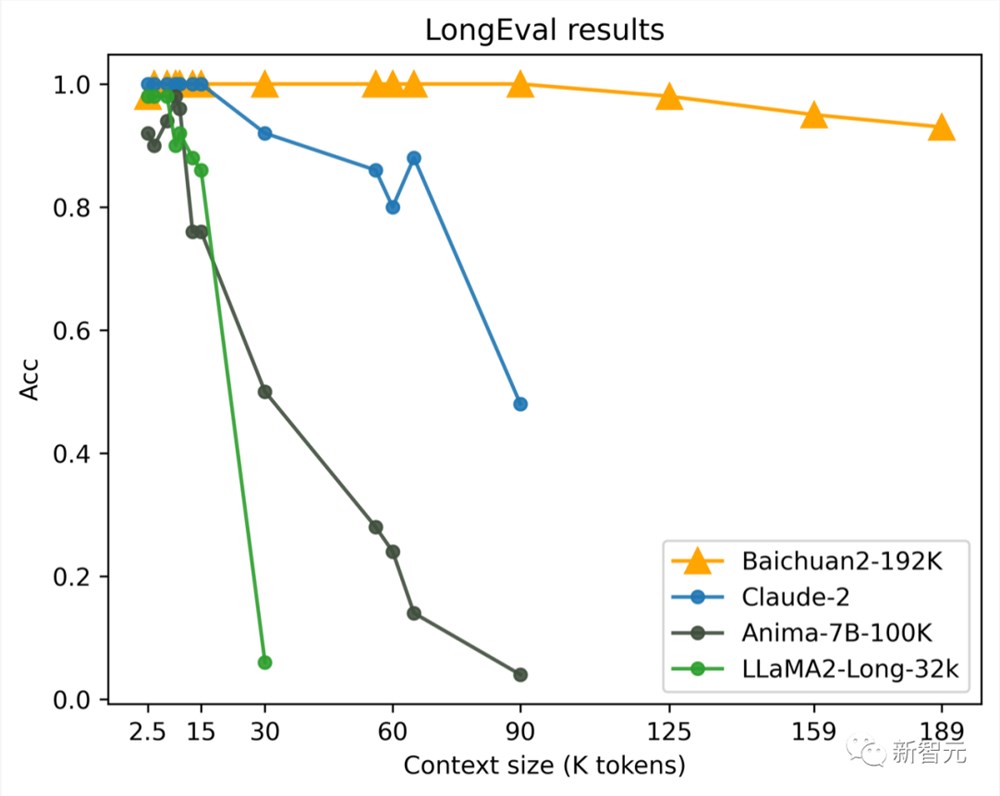

10月30日,百川智能推出的Baichuan2-192K一次可输入35万汉字,是当时世界上最长的上下文窗口模型,解决了知识库、长期记忆、超长文本理解等场景问题。

但是长窗不是万能的。

虽然简单的长窗模型在处理大量数据方面有其优势,但在容量、成本、性能和效率方面都有明显的局限性。

例如,在处理超长文档时,会消耗大量tokens,大大增加推理成本。虽然模型已经实现了「光速阅读」,但每次回答问题时,从头到尾阅读所有信息也会影响效率。

长窗+搜索增强模式可以充分发挥长窗的优势,扩大模型处理信息的能力,大大提高数据处理的效率和准确性。

话不多说,直接看结果。

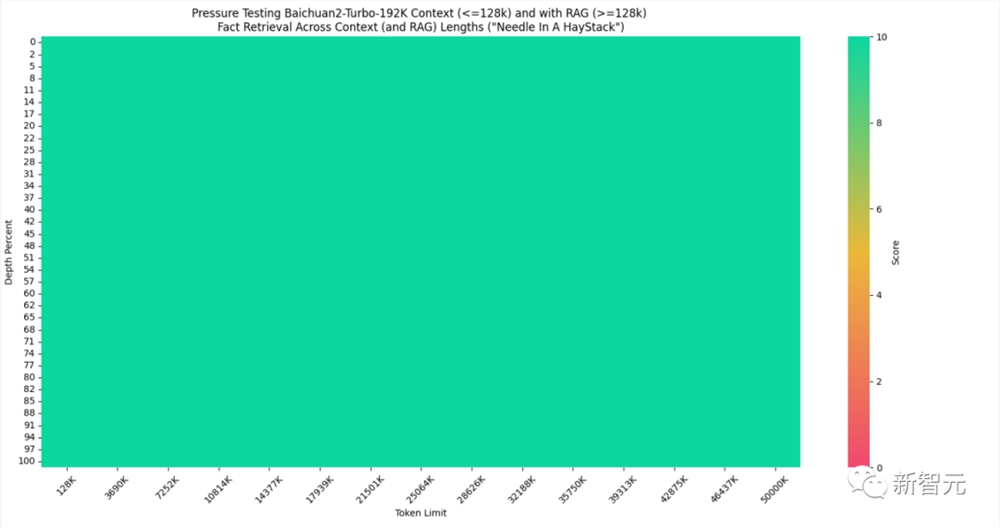

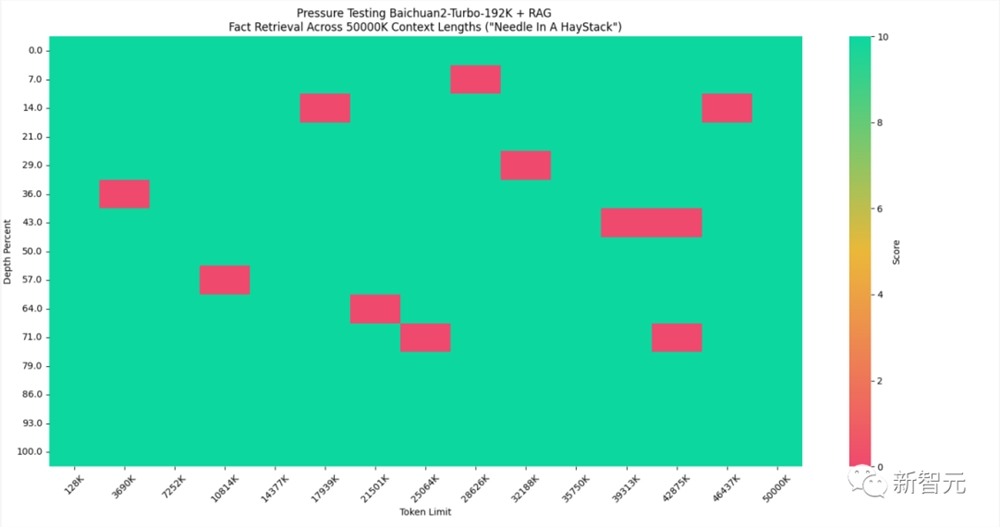

目前,国外知名人工智能企业家兼开发者Greg 设计了Kamradt「大海捞针」(Needle in the Heystack),可以说是业内公认的最多权威测试大模型长文本准确性的方法。

对于192k 百川智能可以通过长窗口+搜索增强tokens以内的请求来实现100%回答精度。

假如再增加两个数量级的测试集呢?

测试结果显示,当数据集扩展到5000万tokens(大致等于9000万汉字)时,稀疏检索+向量检索的方法仍然可以接近全球满分-实现95%的答案精度,而简单的向量检索只能实现80%的答案精度。

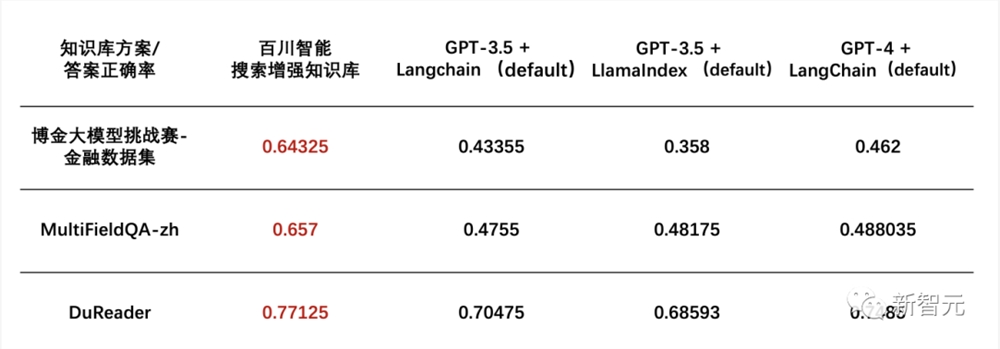

与此同时,百川智能搜索增强数据库的性能也非常出色。

金融数据集(文档理解部分)在博金大模型挑战赛中、MultiFieldQA-GPT-3.5.、GPT-4.行业头部模型。

通过「大模型+搜索」百川智能将大模型时代的内存、硬盘和网络结合起来,实现了完整的技术栈极致,充分发挥成本、性能和效率的优势,为企业应用大模型提供完整的技术解决方案。

可以说,百川智能在引领国内大模型开源生态后,再次引领行业,开启了企业定制的新生态!

参考资料:

https://platform.baichuan-ai.com/playground

https://www.baichuan-ai.com/

Copyright © 2013-2025 bacaiyun.com. All Rights Reserved. 八彩云 版权所有 八彩云(北京)网络科技有限公司 京ICP备2023023517号

本站文章全部采集于互联网,如涉及版权问题请联系我们删除.联系QQ:888798,本站域名代理为阿里云