声明:本文来源于微信公众号 机器之心(ID:almosthuman2014),作者:机器之心,授权站长之家转载发布。

生成式 AI 在3D 长期以来,该领域一直在等待自己「ChatGPT」时刻。

传统3D 建模涉及游戏、影视、建筑等行业,一般依靠专业人员的手动操作,生产周期短至几天,多为月,单个3D 创建模型至少需要几千元。生成式 AI 技术在2D 人们可以看到图像生成领域的成功经验 AI 在变革3D 建模的潜力。一条万亿美元的赛道似乎从此开始,但目前市场上的3D赛道 生成类的 AI 技术仍然存在各种不足,每个人都期待着一个让自己眼前一亮的产品。

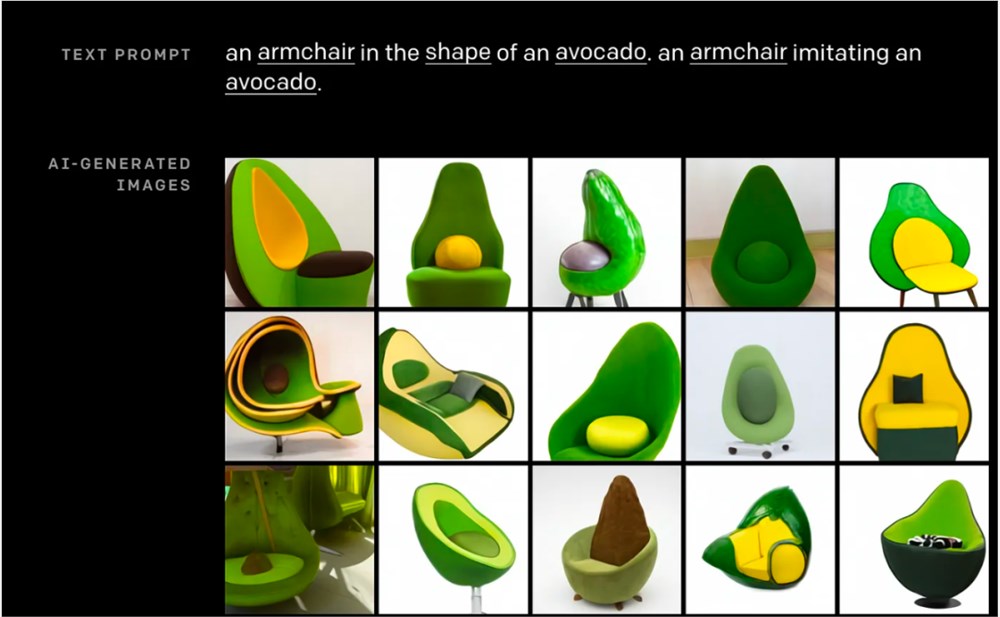

2021年1月初,OpenAI 发布 DALL・E,并输入文本 prompt「一把牛油果形扶手椅」,形象丰富,结构清晰,标志着文字生成图片的技术成熟。

MIT 科技评价:「这把鳄梨扶手椅可能是 AI 的未来(This avocado armchair could be the future of AI)」

Prompt(提示词):an armchair in the shape of an avocado. 图源:OpenAI

2023年12月,机器之心体验 VAST 自研的3D 大模型 Tripo,当经典的「牛油果手扶椅」以精致的形式在我们面前快速丝滑地生成,我们立刻意识到生成 AI 又迎来了一个里程碑时刻。

Prompt(提示词):avocado chair. 图源 TripoAI

VAST 是谁?

经过一番搜索,我们发现最近流行的两个3D项目 生成技术 Wonder3D 和 CSD 都和这家公司有关。

不久前,一个名字 Wonder3D 开发人员发现了开源项目,它可以在3分钟内从单个图像重建高保真纹理网格。在开源平台上 GitHub 上,该项目在短时间内获得了3.3K Github Star:

体验链接:https://huggingface.co/spaces/flamehaze115/Wonder3D-demo

同时,利用图像扩散模型实现3D 理论突破成果的产生「CSD 」也引起了人们的关注:

VAST 之前唯一的公开亮相是创始人在图形学盛会上的 SIGGRAPH 五十周年庆典期间举行 Keynote 演讲。通过当时的报道,VAST 是一家专注于通用3D的公司 大型技术研发和产品落地初创公司。

作为首位在 SIGGRAPH 发表主题演讲的中国企业家,VAST 创始人宋亚晨提到,VAST 目标是减少高质量3D的生产 3D资产和环境所需的专业知识和成本 内容生成变得更容易。

「3D 技术代表了下一个前沿方向,开启了沉浸式表达的新维度。我们相信 AI 任何人都能创造出惊人的3D 内容不受想象力以外的任何因素的限制。」

作为一家初创公司,VAST 为什么创始人能与行业巨头英伟达、索尼、Unity 的掌门人同台演讲?它们是如何推动的? Wonder3D 和 CSD 这样的技术突破

带着这种好奇心,机器之心拜访了它 VAST 办公室在北京。

了解了团队情况后,我们发现 VAST 可以说是「卧虎藏龙」:

算法团队成员来自国内外顶尖拥有丰富人工智能和图形学经验的大学和技术工厂。

CTO 梁鼎师,戴琼海院士,曾担任商汤通用视觉语言大模型发起人、垂直语言大模型负责人,论文40多篇,引用7000次,国内专利100多项,海外专利14项。

胡事民院士前腾讯首席科学家曹炎培师 ARC Lab 和 AI Lab3D 方向专家,论文40多篇,最近3D 生成方向的相关成果包括 Dream3D、DreamAvatar、 Sparse3D、HiFi-123、TGS 等。

郭元晨,一位出生于1997年的年轻科学家,是清华大学的博士生,师从张松海副教授,也是著名的3D 开源项目的生成 threestudio 发起人和核心贡献者。这个项目已经在了 GitHub 社区收获4.4K 到目前为止,星标是功能最完整、应用最广泛的3D 生成代码框架。

threestudio 地址:https://github.com/threestudio-project/threestudio/

随后,VAST 和机器之心谈谈他们正在进行的技术探索。

AI 在3D 如何打破生成领域的壁垒?

我们聊到的第一个问题是:在3D 在内容的生成上,AI 还面临哪些挑战?

要理解这个问题,首先需要理解3D 内容制作的特殊性。

数字3D 内容起源于20世纪60年代的计算机图形学,至今已衍生出许多细分领域。一般来说,完整的3D 生产管道涵盖概念设计,3D 建模、纹理 / 材料、动画、渲染等环节。

在传统过程中,3D 数字内容的生成是通过积累来产生的⻓时间学习和⼯创作经验丰富的专业艺术家,添加⼊了⼤量的⼈⼯经验设计,不同的艺术家⼯不同的过程,没有绝对统一的标准。对于这些。资深的专业3D 对于创作者来说,3D 内容生成也是一项非常复杂和耗时的工作。

此外,3D 数字内容表达的多样性也是 AI 学习过程增加了更多的挑战。多边形⽹格、细分曲⾯、⻣不同的材料涉及不同的渲染管道,如框架动画、顶点动画和物理模拟动画。表达方式的不统一导致3D 内容制作本身比2D内容制作本身要好 更具挑战性。

以我们熟悉的视觉模型和语言模型为例,它们将通过预训练数据进行训练「学习」探索规律,最终表现出非常接近「创造」能力。实现这种学习能力的前提是图像、视频、语音和文字都有一种通用的表达形式。

对于现有的生成式大模型,3D 数字内容就像一个新的数字内容「语言」系统。所以,想让 AI「学会」与人类水平相当的3D生成 同时保证模型的速度并不容易。

已取得阶段性突破的研究大多遵循2D 优化路线:使用现有生成模型的2D 通过多视角优化,生成能力将生成维度提升到三维。

斩获了 ECCV2020最佳论文荣誉提名 NeRF(Neural Radiance Fields,神经辐射场渲染)在多视图重建静态三维场景方面取得了重要进展。这一基础理论的突破开启了一波新的3D波 x AI 在此基础上,一些研究人员引入了从文本到图像生成的扩散模型,如 Google 去年发布的 DreamFusion 提出使用算法「Score Distillation Sampling」从文本到3D的实现 的生成。DreamFusion 优点是几乎不需要提前训练,没有3D就实现了 在生成物体3D数据的情况下 缺点是速度慢(长达几个小时)。

OpenAI 去年同期发布的 Point-E 在3D中使用 还强调了数据培训计划「可以用单块 NVIDIA V100GPU 在一到两分钟内生成3D 模型」,但它从文本到3D 在转换过程中,偶尔无法理解文本叙述的内容,导致生成的形状与文本提示不匹配,生成结果的精细度不足。

总之,对这条路线的后续研究很多,但从来没有一个方案能够兼顾模型的生成质量、速度、多样性和可控性。

「通用3D 大模型」的探索之路

知名计算机科学家 Rich Sutton 2019年的教授曾经是教授《The Bitter Lesson》文章给出了一个论点:对于 AI 在模型培训方面,为了在短期内得到改进,研究人员可以利用特殊领域的人类知识。但如果你想长期提高,更好地利用计算能力是王。

正如早期的 CV 在该领域,人们普遍认为,只要设计出更好的特征描述,就可以不断进步,但后来成功的深度学习方法只能通过积累或注意力机制取得更好的效果。其中 ImageNet 等海量图像数据集,GPU 计算能力强,计算能力强 CNN、Transformer 高可扩展性模型架构起着至关重要的作用。

VAST 认为,AI 要想在3D 随着生成领域的快速发展,也需要跳出对人类知识的依赖,以更大的数据和更多的计算「学习」一种「通用方法」。

具体到3D 领域,让 AI 突破瓶颈「通用能力」什么是方法论?

在 VAST 这个目标似乎还可以从表示、模型和数据三个方向开始。

充分利⽤算⼒最重要的是找到合适的关键「表示」。⽐如3D 三种常用于内容制作⻆⽹格来模拟复杂物体的表面,这是对的 GPU 渲染算⼒友好但对深度学习算法不够友好。

VAST 我希望找到一个更灵活、更有利于计算的3D 统一表示,与现有图形管道兼容。

最近的论文《SC-GS: Sparse-Controlled Gaussian Splatting for Editable Dynamic Scenes》,他们通过将场景运动和外观分解为稀疏控制点和密集的3D,提出了一种新的动态场景表达方法 Gaussians,显著提高了动态场景的可编辑性和渲染质量,在合成和保持新视角外观的运动编辑方面明显优于现有方法。

另一项研究《Triplane Meets Gaussian Splatting: Fast and Generalizable Single-View3D Reconstruction with Transformers》基于三平面进行了探索(triplane)和高斯溅(3D) Gaussian Splatting)融合的3D 表示,利用高度可扩展的 Transformer 架构可在2秒内实现高质量图生3D。

此外,探索「3D tokenizer」这也是一个很好的想法。之前的一项研究表明,如果在相同的训练数据、模型大小和训练预算下使用良好的视觉, tokenizer,在图像和视频基准的生成保真度和效率方面,掩码语言模型也可以达到与扩散模型相同的水平。对于3D 对于生成任务,将3D 表示转化为与语言 token 相近形式的 token 表示,这可能有助于在3D中应用现有的理解和生成大模型 领域。

在「模型」层面,VAST 最近的一些研究探索了如何充分利用大模型在其他模型下的先验、设计准则和培训经验,以提高模型的3D 学习数据的能力。

比如最近爆火的 Wonder3D 创新地提出了强大的2D复用 图像生成模型同步生成多视角的一致方向 RGB 实现了2分钟高质量图生3D。他们使用多视角方法向图表示3D 几何信息可以有效地利用大量的2D 数据先验。

此外,VAST 还在最新的一项研究「UniDream」提出了高质量的可输出 PBR 材料,可重光3D 多阶段文生3D模型 框架。该框架分为三个部分:1. 强大的2D复用 图像生成模型,以文字为条件,同步生成解耦多视角一致的方向和基本颜色;2. 结合大量3D 3D数据训练可泛化 重建模型,从多视角图片生成基本的3D 先验;3. 利用材料解耦 SDS 优化方法,最终获得高质量的几何和 PBR 材质的3D 模型。

「数据」层面的挑战也不容忽视。由于高质量、本地化、多样化的3D 数据集资源稀缺,模型最终性能有限,导致可生成的3D 内容有限,泛化能力不足。这就是为什么一些研究人员试图直接使用3D 数据集训练和微调模型,但都没有达到理想的效果。

针对这个问题,VAST 自2023年初成立以来,3D一直在积累 目前,数据的优势在世界各地都有最大的3D 优质原生数据库(千万级)。

基于千万3D 大模型的原生数据训练

已有落地产品

经过近一年的探索,VAST 通用3D已于今年12月完成 大模型 Tripo 的研发。

VASTAI,赞16

Tripo AI Fantasy: Launched,和艺术家Rui在一起 共创Huang

Tripo 基于海量3D 高质量的原生数据库训练是数十亿参数级别的3D 大模型。得益于 VAST 在「通用3D 大模型」路线上的技术探索,Tripo 行业领先于生产的质量、速度和成功率。目前,带有纹理的3D已经在8秒内生成 网格模型可以进入传统管道进行二次编辑和调整。在此基础上,优化后的3D可以用5分钟进行优化 模型可以接近人类手工制作的3D 模型质量,成功率超过95%。

Tripo 也已于12月21日正式上线,目前支持「文生3D」和「图生3D」两种能力。

前往 VAST Tripo3DTripo免费体验 生成能力:www.tripo3d.ai

我们可以观察, Tripo 具有较强的泛化能力,无论是现实、风格化的任务,还是结构复杂的幻想生物,也可以在短时间内完成,显示在3D 创意内容的巨大潜力。

随着高质量数据集的深入利用和算法的不断进步,Tripo 未来有望在很短的时间内创作出质量堪比人工建模水平的作品。

3D 生成,何时迎来「ChatGPT 时刻」?

在与 VAST 在技术团队的交流中,我们发现通用3D领域处于领先地位 除了大模型的探索,该公司还实现了工业化探索「快人一步」。

不到一年的时间,VAST 已经为国内外搭建了 B 端和 C 端到端产品矩阵与国内外游戏、动画、工业、云计算等行业数十家龙头企业合作 数据及3D 战略合作关系建立在内容生成等领域。

放眼未来,VAST 的「野心」不止于此。成立之初,这个团队就设定了目标:让任何人都成为目标。「超级创作者」,充分实现自己的创造力。

需要承认的是,目前 AIGC3D 技术距离目标还需要一段探索期。但在这场技术浪潮中,VAST 它已成为从0到1的推动者之一。下一步,VAST 克服更多来自现实世界的问题。

在与 VAST 在团队交流中,我们充分感受到了这种坚定的技术热情:

「VAST 相信,当通用3D 大型模型的能力逐渐增强,用户进行3D 创作的门槛会不断降低,真正的3D 内容爆发的时代必然会到来,属于 VAST 这群年轻人『OnePiece』。」CEO 宋亚晨说。

目前,VAST 仍在构建交互式3D 内容平台希望为世界各地的专业人士和业余爱好者创建一个定制的3D共享创作、发现作品和访问 资产交流中心。

也许在不久的将来,3D 像样也会出现在赛道上「ChatGPT」而这样的现象级产品, VAST 这家年轻的中国初创公司特别值得期待。

Copyright © 2013-2025 bacaiyun.com. All Rights Reserved. 八彩云 版权所有 八彩云(北京)网络科技有限公司 京ICP备2023023517号

本站文章全部采集于互联网,如涉及版权问题请联系我们删除.联系QQ:888798,本站域名代理为阿里云