站长之家(ChinaZ.com)12月21日 消息:近年来,大型语言模型(LLMs)在自然语言处理任务中表现出色,但对计算和内存的高需求对内存有限的设备构成了挑战。

本文提出了一种高效运行LLMS的方法,将模型参数存储在闪存中,并在推断过程中按需加载到DRAM。

论文地址:https://arxiv.org/pdf/2312.11514.pdf

该方法包括构建与闪存内存行为协调的推理成本模型,通过减少从闪存中传输的数据量,并以更大、更连续的块读取数据进行优化。

在这个框架中,引入了两种关键技术:窗口策略通过重用以前激活的神经元来减少数据传输,行列捆绑技术增加了从闪存中读取的数据块的大小,以适应闪存的顺序数据访问。

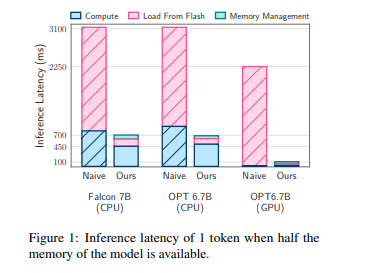

与简单的加载方法相比,CPU和GPU的推断速度分别提高了4-5倍和20-25倍,使这两种方法能够运行比可用DRAM容量大两倍的模型。同时,结合稀疏感知、上下文自适应加载和硬件导向设计,为LLMS推断在内存有限的设备上开辟了新的可能性。

Copyright © 2013-2025 bacaiyun.com. All Rights Reserved. 八彩云 版权所有 八彩云(北京)网络科技有限公司 京ICP备2023023517号

本站文章全部采集于互联网,如涉及版权问题请联系我们删除.联系QQ:888798,本站域名代理为阿里云