声明:本文来源于微信公众号 AI新智能(ID:alpAIworks),作者:举大名耳,授权站长之家转载发布。

在当前的AI轨道上,AI生文、生图的应用早已层出不穷,相关技术也日新月异。

相比之下,AI文生视频,这是一个被“攻下”的位置。

抖动、闪光和持续时间太短。这一系列缺陷使得人工智能生成的视频只能停留在“图一乐”的层面,难以使用,更不用说提供商业赋权了。

直到最近,一个爆炸性的应用,再次引起了人们对这条赛道的关注。

这几天大家一定对这个叫Pika的文生视频AI了解很多。

因此,这里不再重复Pika的各种功能和特点,而是单刀直接讨论一个问题,即:

Pika的出现是否意味着AI文生视频离人们预期的理想效果还有多远?

1

难题与瓶颈

实事求是地说,目前的AI文生视频赛道,难度和价值都很大。

而其中最大难点在于让画面“抽风”的抖动问题。

关于这一点,任何使用过Gen-2Runway的人 等文生视频AI的人,会有深刻的体会。

人们很难获得稳定的生成效果,比如抖动、闪光和不时的图片突变。

这种“鬼畜”现象的背后,其实是帧与帧之间联系不密切造成的。

具体来说,目前的人工智能生成视频技术与早期的手绘动画非常相似。它们首先绘制许多静态图像,然后连接这些图像,并通过逐帧图像实现图像的运动。

但无论是手绘动画还是人工智能视频,关键帧都需要首先确定。因为关键帧定义了特定时刻角色或物体的位置和状态。

之后,为了使画面看起来更流畅,人们需要在这些关键帧之间添加一些过渡画面(也称为“过渡帧”或“内插帧”)。

但问题是,在生成这些“过渡帧”时,人工智能生成的几十帧图像看起来风格相似,但细节非常不同,视频很容易闪烁。

这种缺陷也成为人工智能生成视频的一种缺陷最大瓶颈之一。

而且其背后的根本原因,仍然是所谓的“泛化”问题所致。

用白话来说,人工智能对视频的学习取决于大量的训练数据。如果训练数据中没有特定的过渡效果或动作,人工智能就很难学会在生成视频时如何应用这些效果。

在处理一些复杂的场景和动作时,这种情况尤为突出。

人工智能生成视频除了关键帧问题外,还面临着许多挑战,与人工智能生图等静态任务相比,这些挑战并不难。

例如:

动作的连贯性:人工智能需要了解动作的内在规律,预测物体和角色在时间线上的运动轨迹,才能使视频看起来自然。

长期依赖和短期依赖:在制作视频时,一些变化可能会在很长一段时间内发生(如角色的长期动作),而另一些变化可能会在很短的时间内发生(如物体的瞬时运动)。

为了解决这些困难,研究人员采用了循环神经网络等多种方法(RNN)、长时间记忆网络(LSTM)和门控循环单元(GRU)捕捉时间上的依赖等等。

但关键是,目前的AI文生视频还没有像LLM那样形成统一明确的技术范式。事实上,该行业仍处于探索如何生成稳定的视频的阶段。

2

难而正确的事情

AI文生视频赛道,难度和价值都很大。

它的价值在于它能真正解决许多行业的痛点和需求,不像现在很多“套壳”应用,要么锦上添花,要么圈地自萌。

关于这一点,我们可以从“时间”和“空间”两个维度来审视AI文生视频未来的价值空间。

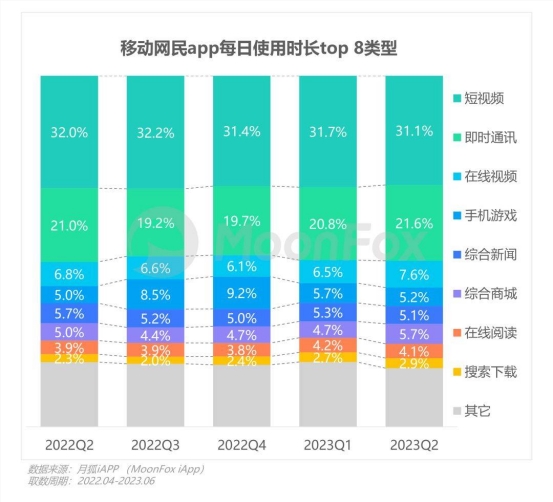

从时间维度来看,判断一种技术是否是“假风口”、假繁荣,最重要的标准之一,这取决于人们未来使用这类技术的频率。

据月狐iAPP统计,从2022年Q2到今年6月,短视频在移动互联网各类APP中的使用时间占30%以上,属于所有类别最高。

除了时间的“纵向”维度外,如果要考虑一种技术的生命力,最关键的指标是空间维度,这取决于它能从多大范围内的群体中受益。

因为任何技术要想“活下去”,就必须像生物一样不断传播和传播自己,在不同的环境中调整自己,从而增加多样性和稳定性。

例如,在媒体领域,根据Tubularr 在Labs的《2021年全球视频指数报告》中,2020年新闻类视频观看量同比增长40%。

同样,在电子商务方面,根据Adobe的一项调查,约60%的消费者在购物时更愿意观看产品视频,而不是阅读产品描述。

在医疗领域,根据Markee全球医学动画市场预计,从2020年到2025年,tsandMarkets的报告将以12.5%的复合年增长率增长。

Hubspot在金融行业的一项研究表明,视频内容在转化率方面表现出色。视频内容的转化率是图形内容的4倍以上。

这种需求表明,从时间和空间的角度来看,视频制作领域是一个增量巨大的“蓄水池”。

然而,要完全释放这个“蓄水池”的潜力并不容易。

因为在各个行业,非专业人士学习如何使用复杂的视频制作工具(如Adobe) Premiere Pro、Final Cut Pro或DaVinci Resolve)可能很难。

对于专业人士来说,制作视频仍然是一个耗时的过程。他们必须从故事板开始,规划整个视频的内容和结构,然后拍摄、编辑、颜色调整等。

有时候,只有一分半的广告视频可能需要一个月的时间。

从这个角度来看,打开AI文生视频的轨道,相当于疏通连接到这个蓄水池管道的“堵塞物”。

此后,隐藏的财富之泉将喷涌而出,为各行业带来新的增量和繁荣。

从这个角度来看,文生视频的轨道,即使很难,也是正确的,值得的。

3

行业引领者

轨道已经确定,更重要的是判断哪些企业或团队会在这样的轨道上脱颖而出,成为行业的领导者。

目前,除了前面提到的Pika,其他类似的企业在AI文生视频的轨道上也经常采取行动。

Adobe,科技巨头 Systems收购Rephraseese.ai,emuta推出emuta Video,Stability Stablee发布了AI Video Diffusion,Runway更新了RunwayML。

就在昨天,AI视频新秀Neverends也推出了最新的2.0版本。

从目前的角度来看,Pika、Emu Video、Neverends等应用,已经显示出很好的实力,其生成的视频,一般都能保持稳定,减少抖动。

但从长远来看,要想在AI文生视频领域保持领先地位,至少要有三个条件:

1、强大的算力

在视频领域,人工智能比以前的LLM更需要计算能力。

这是因为,视频数据包含的时间维度和空间维度高于图片和文本数据。视频模型通常需要更复杂的结构来捕捉视频中的时间动态信息。

更复杂的结构意味着更多的参数,更多的参数意味着所需的计算能力翻倍。

因此,在未来的人工智能视频轨道上,计算能力资源仍然是必须跨越的“硬门槛”。

2、跨领域合作

大型视频模型通常涉及更多的领域,比图片或文本模型更全面。

它需要整合各种技术,如高效的视频分析、生成和处理。包括但不限于:图像识别、目标检测、图像分割、语义理解等。

如果把当前的生成人工智能比作一棵树,那么LLM就是树的树干,文生图模型就是树干延伸出来的枝叶和花朵,而大视频模型就是吸收各个部位(不同类型的数据)的营养后最复杂的果实。

因此,如何通过较强的资源整合能力进行跨领域的交流与合作,成为决定团队创新的关键。

3、技术自主性

正如前面所说,在目前的文生视频领域,行业还没有像LLM那样形成明确统一的技术路线。这个行业正在朝着各个方向尝试。

在不确定的技术方向上,如何给一线技术人员更大的包容性,让他们不断尝试和犯错,探索,已经成为建立团队创新机制的关键。

对于这个问题,最好解决办法是让技术人员亲自指挥,让他们有最大“技术自主性”。

就像Pika Labs创始人Chenlin说:“如果训练数据集不够好看,模型中学到的角色就不会好看,所以你最终需要一个有艺术审美修养的人来选择数据集来控制标记的质量。”

随着企业和团队的不断竞争和行业内新产品的不断涌现,文生视频人工智能的爆发已经成为一个非常具体和可预测的趋势。

根据Pika 根据Labs创始人Demi的判断,行业可能在人工智能视频的“GPT时刻”将于明年迎来。

虽然技术的发展有时不会转移人们的意志,但当对技术的渴望成为行业的共识,使越来越多的资源倾斜时,变革的风暴最终会到来。

Copyright © 2013-2025 bacaiyun.com. All Rights Reserved. 八彩云 版权所有 八彩云(北京)网络科技有限公司 京ICP备2023023517号

本站文章全部采集于互联网,如涉及版权问题请联系我们删除.联系QQ:888798,本站域名代理为阿里云